Dieses Argument verstehe ich nicht. Wenn Autos mit KI-Steuerung im Schnitt weniger Unfälle bauen, müssten doch die Versicherer eigentlich einen günstigeren Tarif für den Auto-Besitzer anbieten. Schuld trägt immer der Fahrzeugführer oder -Halter.

Geht etwas vom Thema hier weg aber es geht nicht nur um finanzielle Haftung bei Personenschäden.

Wieso nicht der Hersteller oder Programmiere, wenn das Auto autonom fährt? Dann gibt es schon mal keinen Fahrzeugführer und der Halter hat auch keinen (oder kaum, bin da nicht sicher wie das ausgestaltet wird) Einfluss auf das Fahrverhalten.

Eher OT hier @moderatoren ggf. Topic zu Haftung bei selbststeuernden Fahrzeugen:

- Die Firmen könnten aus meiner Sicht bestenfalls wegen Fahrlässigkeit eine Teilschuld bekommen?

- Der Hersteller der Servolenkung bekommt bei einem Unfall auch keine Schuld.

- Auch jetzt könnten Hersteller einfach wegen der Möglichkeit schnell zu fahren, des übermäßig hohen Gewichtes des Fahrzeugs im Vergleich zum Fahrrad oder Fußgänger und der harten Karosserie dann eine Teilschuld haben (Pickups, außer Förstern braucht die keiner)

Nicht vergleichbar, die Servolenkung trifft keine Entscheidung.

Ebenfalls nicht vergleichbar, die Hersteller bauen zwar diese Autos, es kommt aber dann eine autonome Entscheidung eines anderen Menschen dazu, das Auto mit unangepasster Geschwindigkeit oder sonst wie unangemessen zu fahren. Wir reden beim autonomem Fahren über eine ganz andere Einflussmöglichkeit des Herstellers und einen massiven Verlust der Einflussmöglichkeit beim Fahrzeugführer, wenn man das denn überhaupt noch so nennen möchte. Auch ggü dem Halter sehe ich die Situation anders, wenn gleich er weniger schutzwürdig sein mag. Aber bisher kann der Halter dadurch Einfluss nehmen, dass er nur die fahren lässt, die er kennt und deren Fähigkeiten er vertraut, zukünftig muss er einem Hersteller dieses Vertrauen entgegen bringen.

Super Thema:

Ich habe vor ca. einem Jahr einen Beitrag bei der ARD (glaube PlusMinus) dazu gesehen. Eher gesagt ging es um die Haftung bei LKW, wenn diese durch die Abstandsregelung sehr dicht auffahren (Autobahn), um Diesel zu sparen.

Der Fahrer hat dann keine Chance mehr rechtzeitig den Bremsvorgang einzuleiten.

Auch hier ist die Haftungsfrage nicht zu klären, ohne den Hersteller mit in die Haftung zu nehmen. Diese wollen das jedoch nicht, weil es ganz einfach dafür keine Versicherung im Moment gibt.

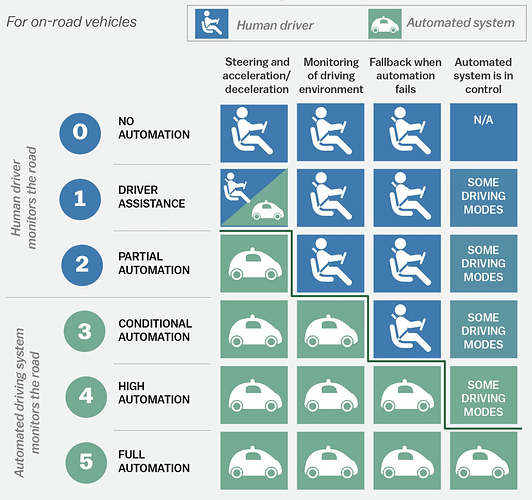

Die Frage lässt sich ziemlich einfach beantworten, wenn man die Definition der Automatisierungslevel heranzieht, die in der SAE J3016 spezifiziert sind. Die Grafik kommt nicht direkt von der SAE, ist aber besser verständlich.

Hier ist klar erkennbar, wo die Grenze verläuft. Erst ab einem Level 4 ist das Auto in der Lage den sog. „sicheren Zustand“ allein herzustellen, also einen Fallback einzuleiten, mit dem es aus jeder Situation heraus Probleme lösen kann. Der Unterschied zwischen L4 und L5 besagt hier nur, dass L4 in definierten Gebieten funktioniert (z.B. wie bei Waymo in einigen US Städten), L5 hingegen überall ohne Einschränkungen.

Auch der Fakt, dass man bei den aktuellen L4 Fahrzeugen, welche kommerziell nutzbar sind nicht am Steuer sitzen kann oder darf zeigt, dass hier der Hersteller haften muss, da ein Mitfahrer keine Möglichkeit hat überhaupt einzugreifen.

Deshalb ist die deutsche Motivation L3 Systeme zu entwickeln auch zu hinterfragen. Bei einem L3 System kann nicht detailliert spezifiziert werden, wann hier der Fahren die Kontrolle übernehmen muss. Dies schafft eine Art Grauzone und hält die Funktionen des Systems stark begrenzt. Man muss nur daran denken, dass Mercedes sich für L3 aktuell feiern lässt, weil das Auto in Sonderfällen bis 50km/h auf der Autobahn ohne Fahrerüberwachung fahren kann (L3), während weltweit schon einige Shuttle (L4) komplett fahrerlos durch die Gegend düsen.

Dass es Regeln dafür geben muss wie eine KI entscheidet ist wichtig, aber aktuell ist es in meinen Augen so, dass man bei gleicher Strenge in der Diskussion auch Operationen oder Impfungen in Frage stellen müsste. Und das tun aktuell ja leider auch nicht wenige.

Gerade bei Impfungen ist ja auch der Fall, dass unter Umständen einzelne unter Folgen der Impfung leiden, die vielleicht die Krankheit gar nie bekommen hätten oder nur harmlos. Hier wird ganz allgemein eine Risikoabschätzung vorgenommen und wenn der Nutzen im allgemeinen größer ist als das Risiko, dann wird die Impfung im allgemeinen oder für einzelne Gruppen empfohlen.

Das gilt aber nur, wenn der Fahrer die Unfallschuld hat. Wenn jedoch die Servolenkung z.B. durch Fertigungsfehler versagt, dann ist selbstverständlich der Hersteller in der Pflicht. Deswegen gibt es ja immer wieder große Rückrufaktionen, die dann auch der Hersteller zahlen muss.

Wenn die deutschen Hersteller sich die Entwicklung von Systemen mit höhere Autonomie-Grad nicht zutrauen bzw. wegen Haftungsrisiken nicht für sinnvoll halten, dann ist das doch gut. Immer noch besser, als wenn sie, wie z.B. Tesla, die Entwicklung und vor allem das Rollout an die Kunden total überhasten und die Tesla-Fahrer damit zu unfreiwilligen Beta-Testern werden.

Das hat mit „für sinnvoll halten“ wenig zu tun. Es ist führt zu einer Grauzone, die im Zweifel gegen den Kunden ausgelegt wird/werden kann.

Mercedes sagt, dass ihr System bis 60km/h ohne Aufmerksamkeit des Fahrers funktioniert, schreibt aber dennoch im Kleingedruckten, dass der Fahrer jederzeit die Kontrolle übernehmen können muss. Das widerspricht sich. Sie preisen also an, dass man aufs Handy/Zeitung schauen darf, darf es aber nicht.

Während des hochautomatisierten Fahrens können Sie das Steuer aus der Hand geben, den Blick vom Verkehrsgeschehen ab- und sich anderen Dingen zuwenden. Damit gewinnen Sie wertvolle Zeit, anstatt sie im Stop-and-Go-Verkehr zu verlieren. Nutzen Sie beispielsweise das In-Car Office, führen Sie Video-Telefonate oder genießen Sie die Entertainment-Angebote an Bord.

Weiter unten:

Der Fahrer muss eine korrekte Sitzposition einhalten und stets zur Übernahme der Fahraufgabe bereit sein. Bei Systemaufforderung oder aufgrund offensichtlicher Umstände muß der Fahrer die Fahraufgabe übernehmen.

Also anderen Dingen zuwenden, aber dennoch immer bereit sein bei nicht näher spezifizierten Problemen. Das finde ich problematisch, da man nicht sofort nach aufschauen direkt Übernahmefähig ist.

Ich möchte bitte langsam mal von diesem Framing der „Verantwortungslosigkeit“ wegkommen, das ist in der Diskussion nicht hilfreich. Unfreiwillig ist da nämlich gar nichts. Jeder Tesla Besitzer hat ein L2+ System, über welches er immer die Kontrolle haben muss, ein klassisches Assistenzsystem wie man es kennt. In den USA erhalten ausgewählte Kunden Zugriff auf die FSD (Full Self Driving) Beta, mit der sie die neuen Features erproben können, ebenfalls unter voller Verantwortung des Fahrers. Diese Verantwortung wird in der Community auch sehr ernst genommen. Diese Verantwortung muss auch jeder Kunde beim Aktivieren der Features mit Haken bestätigen, sonst geht das Feature nicht. Kann jeder frei entscheiden.

Bei Impfungen ist es aber doch so das hier die möglichen Folgeschäden auch getragen werden. Zumindest bei der Corona Impfung war es doch die Diskussion das der Staat hier Sicherheiten übernommen hatte,oder?

Das wurde meines Wissens nur gemacht, weil Zeitdruck herrschte. Dieser herrscht m.E. beim Thema autonomes Fahren nicht.

Ist korrekt, ist auch nicht notwendig. Der Hersteller wird aufgrund der ihm auferlegten Haftung ein Eigeninteresse haben ein sicheres Fahrzeug auf den Markt zu bringen, da er sonst anderenfalls mit hohen Kosten und vor allem Strafverfahren rechnen muss.

Wir haben hier ein typisches Kutschen vs. PKW Problem.

L3 Systeme würden sehr schnell in L4 Systeme (wahrscheinlich L5) transferiert werden, wenn alle PKW und LKW und Busse dieses Systeme hätten und untereinander kommunizieren würden.

Da wir jedoch eine Übergangszeit haben werden müssen die Systeme mehr können, als in einer späteren Ausbaustufe.

Bsp.: LKW. Die Systeme, dass LKW auf Autobahnen L4 haben, existieren. Die Störungen kommen durch PKW und nicht ausgerüstete LKW. Daher wird auf L3 gegangen.

Der Hersteller, soweit mir bekannt, übernimmt aber keine Haftung bei Unfällen und muss Schmerzensgelder bezahlen.

Das sehe ich nicht so. Diese These basiert darauf, dass die Systeme nur nicht so gut funktionieren, weil es eben externe Faktoren wie Menschen/Natur gibt. Aber genau das macht ja ein L4 System aus. Es kann sich in einer Umgebung zurecht finden, die nicht in Gänze kontrollierbar ist. Das reine ergänzen einer V2V Kommunikation ändert daran gar nichts.

Waymo und Otto erproben schon länger L4 Systeme in LKWs, Waymo ist in autonomen Shuttle PKWs marktführend. Diese Systeme fahren schon heute, und vor allem fahren sie nach L4 komplett ohne Fahrer und sind nicht auf L3 mit Sicherheitsfahrer zurückgefallen. Ich bin diese Waymo-Shuttles in meinem letzten Urlaub gefahren, das Auto kommt leer an, sammelt einen ein und fährt nach absetzen wieder leer ab.

Damit steht der aktuelle technische Sachstand auf den Straßen der Welt gegen deine These.

L3 ist eine Sackgasse, die Firmen wie Waymo komplett überspringen, einfach weil diese Grauzone die L3 schafft nicht überbrückbar ist.

Nimm eine Autobahnfahrt mit definierten Zonen, in denen man hochautomatisiert fahren. Der Fahrer sitzt dort, das Auto macht bis 60km/h sein Ding und dann ist der sichere Bereich zu Ende oder es wird schneller als 60km/h (auflösender Stau). Der Fahrer reagiert aber nicht (z.B. eingeschlafen). Was macht das System? Würde es einen sicheren Zustand herstellen können, müsste es ein L4 System sein. Ist es aber nicht. Also muss der Fahrer übernehmen, was er nicht tut. Das System MUSS den hochautomatisierten Fahrmodus abbrechen, weil es nicht mehr sicher ist, kann aber nicht übergeben, weil der Mensch nicht übernimmt. Wer trägt die Haftung?

Anderer Fall (sicher ein Edge Case): Unfall auf der Autobahn, große Trümmerteile/Ladung fliegen auf die Gegenfahrbahn. Das Auto fährt hochautomatisiert. Entweder kann es den Unfall vorhersehen (die Zukunft vorhersehen) und rechtzeitig aufgrund „offensichtlicher Gründe“ an den Fahrer übergeben oder es kann die Situation selbst lösen und den sicheren Zustand herstellen, was es nicht kann, denn dann wäre es L4. Wer trägt die Haftung?

Es hat einen Grund warum man sich in dem Top-Unternehmen des Segements nur auf L4 und L5 fokussiert. Der Fahrer, bzw. der Wechsel zwischen Fahrer und Maschine ist sehr problematisch.

Das stimmt, was du schreibst.

Wenn man jedoch die Variable „andere PKW, LKW, Bus“ aus der Gleichung genommen wird und sogar das eigene System unterstützt, wird die Komplexität reduziert und L4 ist leichter und einfacher erreichbar. Damit würde L3 sofort überflüssig.

Das ist ja grundsätzlich technisch korrekt, ist aber vollkommen unrealistisch und daher nicht weiter zu betrachten.

Es ist am Ende wie die Aussage, dass man nur alle Verbrenner gegen Elektro tauschen muss, dann wären wir sofort Emissionsfrei was den PKw Sektor angeht. Theoretisch korrekt, praktisch nicht realistisch, sondern eine Frage von Jahrzehnten.

Ja, aber hier ist ja die Situation auch eine Andere. Wir reden ja von Millionenfachen Impfungen mit den Selben Impfstoff. Bei einer relativ kurzen Testphase. Auch wenn das Risiko von Zeitversetzten Folgen wohl gegen Null tendiert, so würde es, wenn es in großer Zahl dann doch Eintritt einen riesigen Schaden verursachen. Analogie wäre hier wohl am ehesten das Thema Versicherung von Atomkraft.

Bei Autos würde es ja schon nach wenigen Zwischenfällen zu Rückrufen und Stilllegungen kommen.

Der Kritischste Bereich beim autonomen Fahren ist vor allem die Zeit in der Autonomes Fahren und manuelles Fahren parallel stattfindet. Ich denke bei rein autonomen Fahren wären die Risiken weitaus geringer.

Der Mensch, der nicht übernimmt. Aus welchem Grund ist egal.

Derjenige, der den Unfall, aufgrunddessen die Trümmerteile entstanden sind, verursacht hat.

Da seh ich keine rechtliche Grauzone. Bei einem L3-System ist grundsätzlich erst mal der überwachende Mensch verantwortlich, außer es wird im Einzelfall festgestellt, dass die Automatik dem Menschen keine realistische Chance gelassen hat, seiner Pflicht zur Überwachung/Eingreifen nachzukommen - z.B. weil das System in einer für den Menschen nicht erwartbaren Weise agiert hat und dadurch eine Gefahrensituation überhaupt erst herbeigeführt hat (etwa unbegründetes starkes Beschleunigen oder Bremsen). Diese Fälle wären rechtlich dann dasselbe wie eine Servolenkung, die aufgrund eines Konstruktionsfehlers plötzlich nicht mehr nach links lenkt, obwohl der Mensch am Lenkrad zerrt.

Die Grauzone besteht im Feature-Design und Marketing: es ist natürlich weniger attraktiv, ein L3-System zu vermarkten, bei dem man nicht davon reden darf, dass es „autonomes Fahren“ ist, und bei dem man stets darauf hinweisen bzw. sogar noch durch Überwachung des Fahrers sicherstellen muss, dass der Fahrer immer die Fahrsituation überwachen und ggfs. eingreifen muss, als etwas namens „Full Self-Driving“. Deswegen sehen wir ja reihenweise - Tesla ist sicher der bekannteste Extremfall - massive Übertreibungen in den Behauptungen, was die Autos nicht alles könnten. Es ist auch grundsätzlich aus Usability-Sicht nicht attraktiv, überhaupt das Feature einer weitgehenden autonomen Steuerung zu bauen, die stundenlang überwacht werden muss, wobei sie schon so gut ist, dass sie nur alle paar Stunden mal ein Eingreifen erfordert.

Deswegen stimme ich deiner Grundthese schon zu: L3 ist problematisch, und es gibt gute Gründe, L3-Systeme gar nicht erst zu vermarkten. Das Hauptproblem ist aber nicht ein undefiniertes juristisches Feld in Bezug auf Situationen wie die von dir beispielhaft skizzierten, sondern eher die mindestens an bewusste Irreführung grenzenden bzw. in Teilen klar bewusst irreführenden Vermarktungsstrategien. Da gehört wesentlich kräftiger und für die Unternehmen schmerzhafter draufgeschlagen als das derzeit passiert - z.B. indem man knallhart eine Haftungsumkehr (sprich: Hersteller haftet immer, egal ob der Fahrer korrekt überwacht) verfügt, wenn in der Werbung suggeriert wird, ein L3-System sei „vollautonom“ und bedürfe eigentlich keiner Überwachung. Wenn dann manche L3-Systeme gar nicht auf dem Markt ankommen, weil’s für die Hersteller zu heikel wird, so be it, das würde ich nicht als Verlust betrachten.