Zufällig habe ich vor vielen Jahren mal als Hardware-Entwickler in einer sehr kleinen Firma gearbeitet und genau solche Anleitungen, wie du sie beschreibst, auf Deutsch und Englisch für kleine Automatisierungskomponenten (für die Hutschiene) auch selbst geschrieben.

Diese Arbeit war aber sehr überschaubar, da ich einfach eine existierende Anleitung für ein ähnliches Gerät genommen habe und lediglich die Bilder und Textteile getauscht habe, die sich geändert hatten.

Der wichtigste Teil der Arbeit war, dass die Zahlen (z.B. Spannungsfestigkeit) gestimmt haben, was keine KI überprüfen kann, weil sie die richtigen Zahlen nicht kennt, und das die Logos für die eingehaltenen Normen stimmten. Und so wird es in anderen Firmen auch sein.

Texte oder Textbausteine, die man schon mal selbst geschrieben, geprüft und veröffentlicht hat, zu recyclen, ist mMn viel produktiver, als sich etwas Neues von der KI generieren zu lassen, das man dann erst einmal aufwendig auf Fehler und Halluzinationen prüfen muss.

Deswegen bin ich auch immer so skeptisch, wenn aus irgendwelchen möglichen use cases immer gleich die großen Produktivitäts-Gewinne abgeleitet werden.

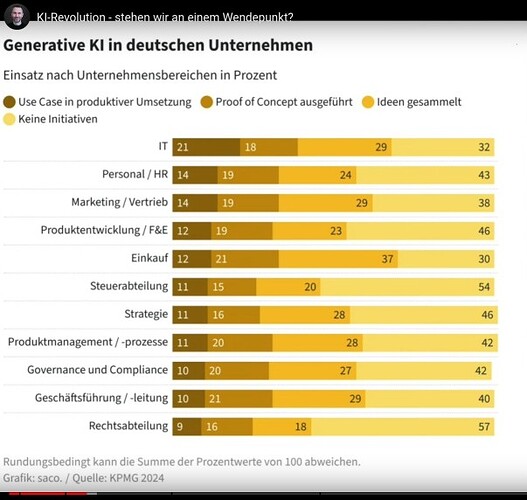

Ausnahmsweise habe ich mir das Video mal (halb) angesehen, ist ja zumindest ein Uni-Prof, der da redet (Link zur Uni-Seite). Leider finden sich da wenig belastbare Zahlen. Diese Daten, aus einer KPMG Studie (Link zu KPMG) vom März diesen Jahres, sind da schon das aussagekräftigste (bei 2:00 min) :

Wenn man in der Original-Studie mal nachschaut, welche KI-Tools gemeint sind, dann wird da lediglich vom MS Copilot gesprochen. Das überzeugt mich eher wenig. Vielleicht geben die Manager das auch nur an, weil sie den MS Copilot ja monatlich bezahlen und sie diese Kosten irgendwie rechtfertigen müssen.

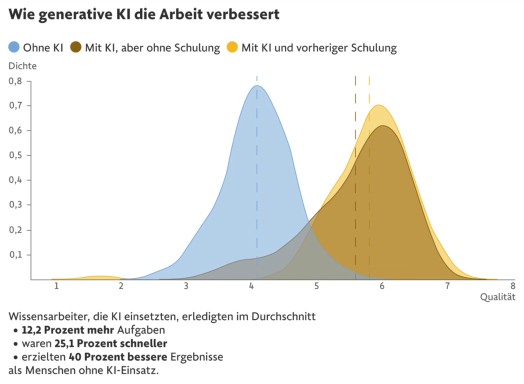

Diese zweite Grafik (bei 3:17 min), die eine Studie zitieren soll, finde ich noch weniger aussagekräftig und die Kategorien „mehr Aufgaben erledigen“ und „schneller arbeiten“ sind mMn synonym und müssten daher gleiche Werte enthalten:

Und in der dritten Grafik (bei 4:06 min), die eine Studie zitiert, wird im Bild nur noch von Potentialen gesprochen, auch wenn Herr Prof. Ahlemann das in seinen Video-Ausführungen unter den Tisch fallen lässt und eher so tut, als wäre das alles schon heute Realität:

Im restlichen Video geht es dann nur noch um einen historischen Rückblick. Und insgesamt ist die Faktenlage was die heutigen Produktivitätsgewinne angeht sehr dünn. Mich hat es nicht überzeugt.

edit:

Wenn man mal einer genannten Statistik folgt (der bei 3:22), stellt sich heraus dass die zugrunde liegende Studie noch kein Peer Review durchlaufen hat

Hast du da mal einen Link zu der Studie? ![]()