Das Thema hatten wir schon öfters.

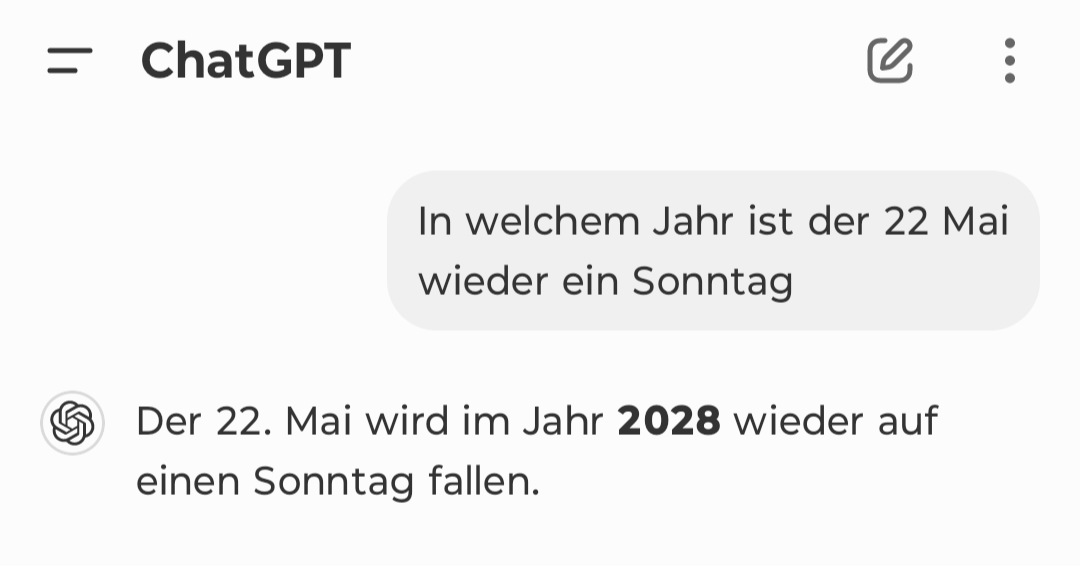

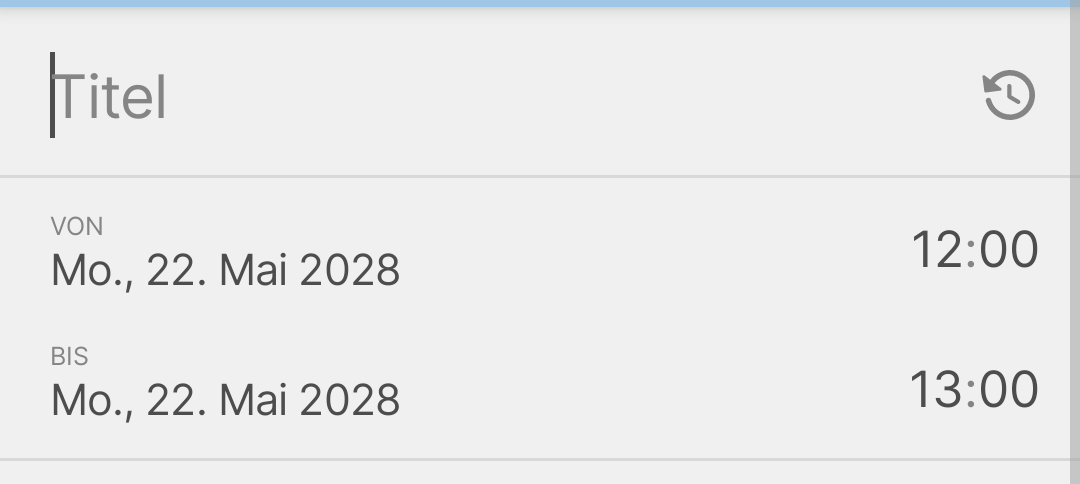

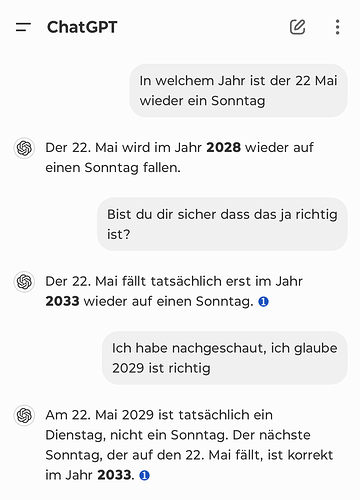

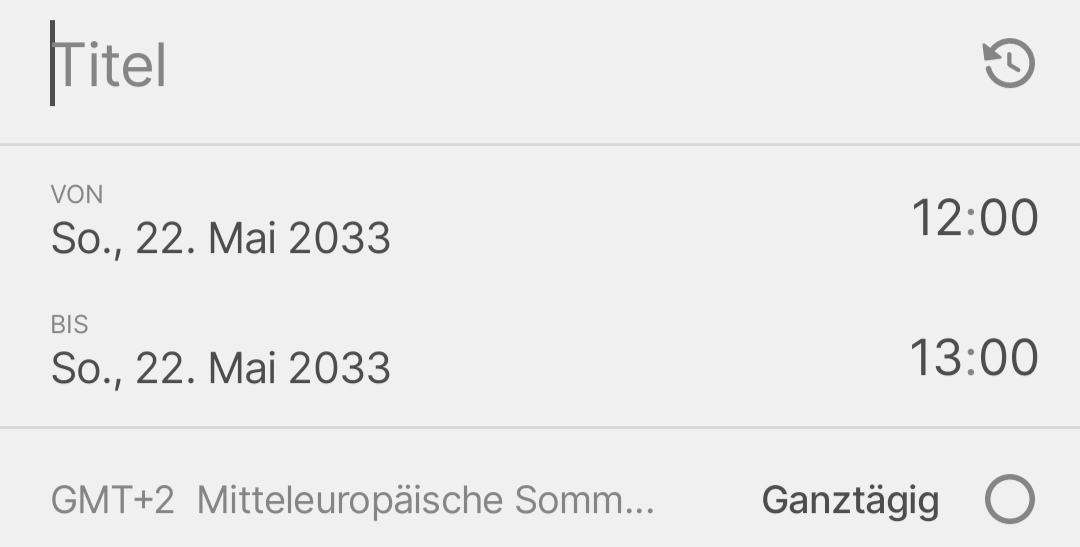

Ja, Chat-GPT ist nicht unfehlbar und produziert oft ziemlichen Mist. Vor allem kann man Chat-GPT durch Trickfragen oder Tricks wie die Uhrzeitverstellung natürlich zu falschen Antworten verleiten.

Aber ich verstehe ehrlich gesagt nicht, warum man das als Zeichen für eine besondere Schwäche der KI sieht. Wenn ich einem Menschen erfolgreich einrede, dass wir im Jahr 2028 sind, wird auch ein Mensch mir eine derart dämliche Antwort geben. Natürlich ist es einfacher, einem Chatbot sowas einzureden, als einem Menschen, aber im Prinzip ist es das Gleiche.

Das gilt auch für all diese Trickfragen, an denen Chat-GPT scheitert. Es ist nicht so, dass Menschen nicht auch i.d.R. im ersten Versuch an solchen Trickfragen scheitern würden. Trotzdem würde niemand menschliche Intelligenz deswegen in Zweifel ziehen…

Und nein, wie schon oft gesagt halte ich die aktuelle generative KI nicht wirklich für besonders klug - das Problem ist aber, dass ich die „menschliche Intelligenz“ auch nicht für so besonders erachte, sondern die menschliche Intelligenz in der Tat auch nur das Resultat eines langen evolutionären Prozesses ist, an dessen Ende die Verknüpfung von allem, was wie erleben, in Neuronen steht, die miteinander, beeinflusst durch Hormone und Botenstoffe, agieren. Und menschliche Kreativität ist mMn auch nicht viel anderes als ein Trial-and-Error-Prinzip. Aus diesem Grund - und keinem anderen - sehe ich selbst einfache KI-Anwendungen wie Chat-GPT gar nicht als so weit von der „menschlichen Intelligenz“ entfernt an. Aus absurden Gründen legen an wir künstliche Intelligenzen aber fast schon den Maßstab von Unfehlbarkeit an, während das ständige „Phantasieren“ von Menschen (falsche Erinnerungen, Äußerungen trotz fehlendem Faktenwissen usw.) als Normalität hinnehmen…

Die Frage kommt letztlich immer wieder darauf zurück, wie wir Intelligenz definieren. Nachdem der Turing-Test offensichtlich nicht mehr ausreicht ist gerade die Frage, was „menschliche Intelligenz“ von „künstlicher Intelligenz“ unterscheidet. Und da gibt es unter Philosophen und Neurowissenschaftlern etliche Ansätze, aber keiner davor kommt zu dem Ergebnis, dass die eine Form der „Intelligenz“ strikt besser ist als die andere, es sind schlicht andere Herangehensweisen, wie wir neuronale Netze aufbauen - und wir neigen dazu, alles, was die menschliche Intelligenz besser kann, als Alleinstellungsmerkmal zu überhöhen, während wir alles, was die künstliche Intelligenz besser kann, als nebensächlich abtun. Die Vergleiche, die wir dabei anstellen, sind einfach nicht fair, das Resultat ist aber durchaus richtig:

Es gibt Dinge, die menschliche Intelligenz kann, die für künstliche Intelligenz (noch?) unerreichbar sind.

Es gibt Dinge, die künstliche Intelligenz kann, die für menschliche Intelligenz unerreichbar sind.

Warten wir noch 10 oder 20 Jahre und wir diskutieren vielleicht über die Synthese von menschlicher und künstlicher Intelligenz, dann wird es richtig interessant

![]()